复习 ¶

约 11984 个字 预计阅读时间 47 分钟

简介

一、选择题:202 单多混选* 真 nt 啊!!!

二、填空题:每空1分,共10分

三、大题/简答题 共50分

重点掌握 ¶

- 人工智能导论部分的概念背诵

- 盲目搜索几种算法的原理、优缺点

- 启发式搜索几种算法的原理、优缺点;A* 的步骤;

- 逻辑:谓词逻辑;归结原理

机器学习:

- 概念学习:定义;Find-S;候选消除算法

- 性能度量:recall precision f1-score

- 决策树:信息增益的计算;

- 神经网络:过拟合;正则化;

- 贝叶斯:极大似然估计;naive-bayes:iid假设

- 强化学习:免模型、有模型学习

统计学习资料 ¶

ZJU_Stat_Courses/ 统计学习 at main · Frankgu3528/ZJU_Stat_Courses

ISLR

统计学习 2023-2024 春夏 ¶

-

简述 Ridge,Lasso Regression,还有 Elatic net

-

Confusion Matrix

- 一个平衡样本做二分类问题

- 给定 accuracy 以及 FN,求 TNR

-

Bias-Variance Tradeoff,三道选择题

- 正则化项会导致 bias 和 variance 如何变化

- irreducible bias 来源

- 如何才能降低 irreducible bias

-

决策树,不剪枝,四道判断 + 论述

- 如果有 X1 在 DGP 中与 Y 独立,则不会进入决策树

- 决策树的最大深度是 log2(n)+1

- 如果做 bootstrap 抽样训练 B 棵树然后取平均,是随机森林

- 随机森林只能做预测,不能做分类

-

聚类

- 给样本点和初始的 C,手算一个 K-means(k=3)任务

-

因果推断

- 简述 G-formula

- 简述 IPTW

-

工具变量

- 简述 IV

- 描述 always taker,never taker,defier,compiler 是什么

- 给定 A 和 L,判断是哪一类

- 什么是 CATE,如何识别

统计学习 19-20 春夏 ¶

一、不定项选择(5 题

-

模型选择与正则化相关概念

-

引起随机森林过拟合的可能原因

-

对 \(n\) 个数据进行硬间隔线性 SVM 分类,有 2 个支持向量,增加一个数据,最大的支持向量数

-

来自多个不同概率分布的总体的数据构成一个数据集,对该数据集使用 k-means 聚类分析,影响聚类效果的因素

-

LASSO 与 PCA 比较

二、判断题(5 题

-

3-NN 模型比 1-NN 模型 bias 小

-

深度为 3 的树比深度为 1 的树 variance 大

-

(不记得了)

-

假设空间越大,过拟合的可能性越大

-

Boosting 采用指数损失函数

三、简答题(4 题

-

给出了一张表,包括参与拟合 SVM 的数据和拟合结果中的系数,判断哪些数据是支持向量

-

给出了 Ridge Regression 的损失函数,解释其中参数 \(\lambda\) 的作用,当 \(\lambda\) 很大或很小时会有什么结果

-

给出一组数据,判断下列分类方法是否可以对这组数据进行正确分类:

- Logistic Regression

- SVM(Linear Kernel)

- SVM(RBF Kernel)

- Decision Tree

- 3-NN

-

给出 \(L_2\) 正则化的线性回归的模型和具体算法

四、 题干大意是用3-order的polynomial regression生成了一组数据

(1)用不同 order 的 polynomial regression 对上述数据进行拟合,判断 bias 和 variance 大小: \(d=1\), \(d=3\), \(d=10\)

(2)在下列情况下使用 flexible 的模型是否比 inflexible 的模型更好,并说明理由: ① predictor与feature有显著的非线性关系 ② 随机误差 \(\epsilon\) 的方差很大

五、k-means:

给了一组数据并给出了预先设定的 centroid,做出第一步迭代后的聚类图,并判断再进行一步迭代后,聚类是否发生变化

六、

题干大意是给了一组数据,拟合了一个模型,进行了变量选择,并求了不同变量数时的 LOOCV,给出了 train error 和 LOOCV 随变量数 \(d\) 的图象

(1)解释上述图象为什么是这样的

(2)\(d\) 为多少时开始过拟合

(3)你觉得 \(d\) = 多少更合适

七、二次 SVM:

核函数为 quaratic kernel(给了损失函数) 给出一组数据,绘制出 \(C\) 很大/小时的决策边界,并判断哪个更好

八、R 代码题

导入了一个数据集,用 gam 拟合了 3 个模型:

\(\text{out1} = \text{gam}(y \sim x)\)

\(\text{out2} = \text{gam}(y \sim \text{as.factor}(x))\)

\(\text{out3} = \text{gam}(y \sim s(x))\)

1. 这三个模型中,第一个模型最光滑,第二个模型最曲折,第三个居中,试解释原因

2. 给出了上面三个模型的 summary,根据对这三个模型做一些评估(问的比我这里更具体一些,比如从拟合训练数据角度哪个更好、从 AIC 角度哪个更好等等)

背诵手册 ¶

人工智能定义:用计算机模拟或实现的智能,研究如何在机器上实现人类智能。用机器来模仿人的智能,又称机器智能。

人类智能具有的 4 项特性为:自主性、反应性、适应性、社会性

人工智能的三大学派:符号学派、连接学派、行为学派

图灵测试:让一台计算机和测试者分开,通过键盘等装置实现询问,如果一台计算机能够让 30% 的人误以为它是人而不是计算机,那么就通过了图灵测试。

知识的特性:相对正确性、不确定性、可表示性

一个智能程序高水平的运行需要有关的事实知识、规则知识、控制知识和元知识。

原子公式由若干谓词符号和项组成

- 人工智能的短期和终极目标 "

短期目标:制造智能机器

终极目标:实现机器智能

PEAS: 1. Performance(性能)2. Environment(环境)3. Actuators(执行器)4. Sensors(传感器)

概念学习的定义:

给定一个样例集合以及每个样例是否属于某个概念的标注,怎样推断出该概念的一般定义

h(n) 从 节点 n 代表的状态 到 目标状态 的 路径耗散 的 最小估计值

- 准确率 - 精确率 - 召回率 - F1-score - ROC曲线 - AUC曲线 - cross-entropy

- MSE:Mean Squared Error ( 均方误差 ),又称 L2 loss

- RMSE:Root Mean Squared Error (均方根误差)

- MAE:Mean Absolute Error (平均绝对误差),又称L1 loss

- l1-smooth:L1正则化  - MBE:Mean Bias Error (平均偏差误差) 没有取绝对值

- R2

- R2_adjusted

- MBE:Mean Bias Error (平均偏差误差) 没有取绝对值

- R2

- R2_adjusted

小测题目 ¶

搜索 ¶

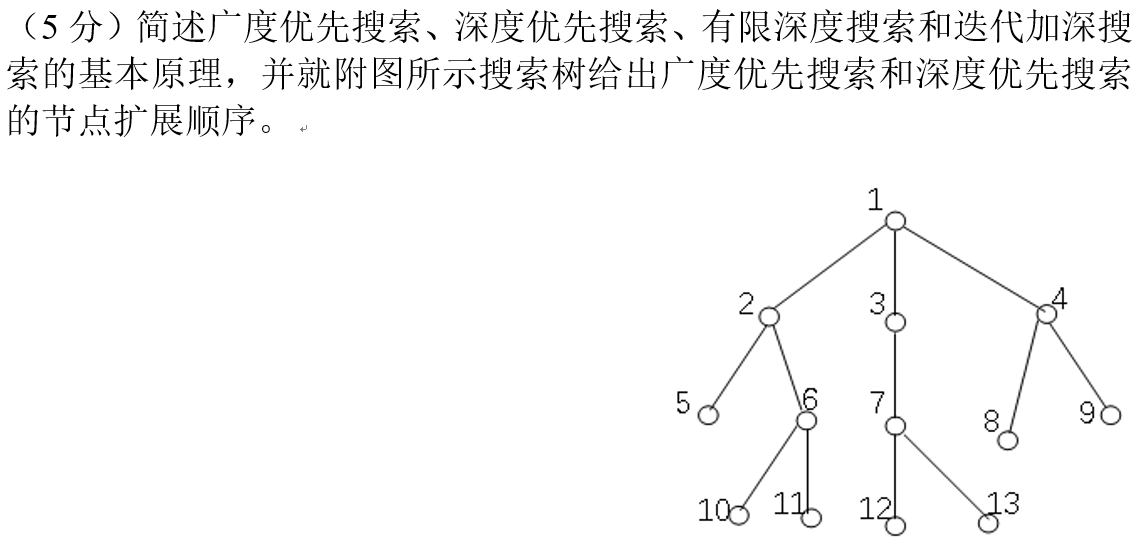

1. 广度优先搜索(BFS)

1. 广度优先搜索(BFS)

- 基本原理:从根节点开始,先访问当前层的所有节点,再访问下一层节点。使用队列存储待访问节点(先进先出)

- 对于图中搜索树的BFS扩展顺序:1-2-3-4-5-6-7-8-9-10-11-12-13

-

深度优先搜索 (DFS)

- 基本原理:从根节点开始,沿着一条路径一直搜索到底,直到不能再深入才回溯到上一个节点继续搜索。使用栈存储待访问节点(后进先出)

- 对于图中搜索树的DFS扩展顺序:1-2-5-6-10-11-3-7-12-13-4-8-9 -

有限深度搜索

- 基本原理:是DFS的改进版本,设定一个最大搜索深度,超过该深度就回溯。

- 特点:避免了DFS可能出现的无限递归问题,但可能错过解。 -

迭代加深搜索

- 基本原理:将有限深度搜索从小到大反复进行,每次增加最大深度限制。

- 特点:结合了BFS找到最短路径的优点和DFS空间效率高的优点。

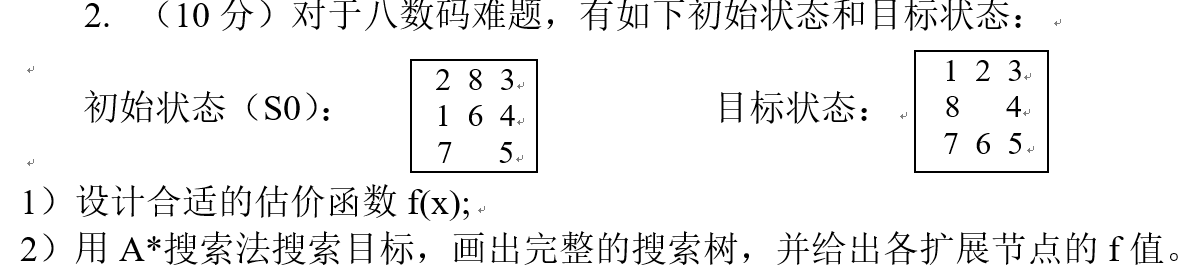

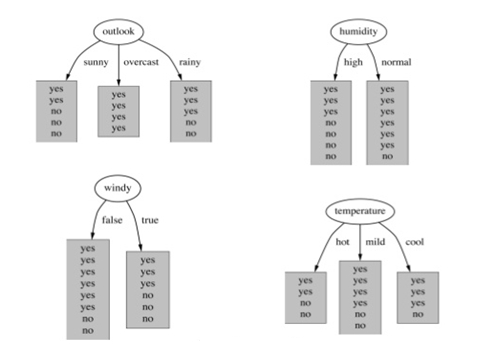

g(x) 为已经走过的步数,h(x) 为初始状态各数字与目标状态各数字的曼哈顿距离之和

谓词逻辑 ¶

有如下事实:

- 所有伟大的厨师都是意大利人

- 所有意大利人都喜欢享用美食

- 迈克尔(Michael)或路易斯(Louis)是一位伟大的厨师

- 迈克尔不是一位伟大的厨师

因此,路易斯喜欢享用美食

请:

1. 定义合适的谓词(1.5 分)

定义如下谓词 :

\(GC(x)\): x 是一位伟大的厨师

\(I(x)\): x 是意大利人

\(EF(x)\): x 享用美食

2. 使用定义的谓词表述上述语句(2.0 分)

谓词逻辑表达:

1) \((\forall x)(GC(x) \Rightarrow I(x))\)

2) \((\forall x)(I(x) \Rightarrow EF(x))\)

3) \(GC(\text{Michael}) \lor GC(\text{Louis})\)

4) \(\neg GC(\text{Michael})\)

因此: 5) \(EF(\text{Louis})\)

3. 将谓词语句转换为标准子句(2.5 分)

转换为子句(量词实例化和蕴含消除):

1) \(\neg GC(x) \lor I(x)\)

2) \(\neg I(y) \lor EF(y)\)

3) \(GC(\text{Michael}) \lor GC(\text{Louis})\)

4) \(\neg GC(\text{Michael})\)

4. 应用归结方法证明结论⑤,画出归结过程并标注出合适的合一(4 分)

否定结论 :

5) ~EF(Louis)

机器学习 ¶

1. 神经网络中的权重调整是通过以下哪种算法实现的 ?

A. 梯度下降 B. 牛顿法 C. 拟牛顿法 D. 共轭梯度法

答案:A。神经网络训练过程中主要使用梯度下降及其变体来优化权重。

2. 在神经网络中,反向传播算法主要用于以下哪种目的 ?

A. 优化权重 B. 计算损失函数 C. 更新输入层 D. 确定输出层

答案:A。

反向传播算法的主要目的是计算梯度并优化网络权重。

3. 在多层感知器中,激活函数的作用是 ?

A. 引入非线性 B. 确定神经元的输出 C. 计算损失函数 D. 控制神经元的输入

答案:A。

激活函数引入非线性变换,使网络能够学习复杂的非线性映射关系。

4. 在卷积神经网络中,卷积层的作用是 ?

A. 对输入数据进行局部感知 B. 实现数据的高维表示

C. 对数据进行全局感知 D. 实现数据的降维表示

答案:A。

卷积层通过局部感受野对输入特征进行局部特征提取。

5. 在深度神经网络中,当数据维度很高时,通常采用哪种策略来处理 ?

A. 数据降维 B. 数据增强 C. 数据归一化 D. 数据标准化

答案:A。

高维数据通常需要通过降维来减少计算复杂度并避免维度灾难。

请简述在神经网络学习模型训练过程中,过拟合和欠拟合的概念及其产生原因。

过拟合 (Overfitting):

- 概念:模型在训练集上表现很好,但在测试集上表现差

- 原因:

1. 模型过于复杂,参数过多

2. 训练数据量不足

3. 训练时间过长

欠拟合 (Underfitting):

- 概念:模型在训练集和测试集上都表现不好

- 原因:

1. 模型过于简单,无法捕捉数据特征

2. 特征选择不当

3. 训练不充分

11. 下列属于无监督学习的是()

A. k-means

B. SVM

C. 最大熵

D. CRF (条件随机场,一种判别式概率无向图模型,常用于序列标注任务)

答案:A。k-means是一种典型的无监督聚类算法。

12. " 过拟合 " 只在监督学习中出现,在非监督学习中,没有 " 过拟合 ",这是()

A. 对的

B. 错的

答案:B。过拟合现象在无监督学习中同样存在。

13. 在下面哪种情况下,一阶梯度下降不一定正确工作(可能会卡住

A.

B.

C.

D. 以上都不正确

答案:B。在局部最小值点处,梯度为0,一阶梯度下降可能会停止。

14. 下列哪个函数不可以做激活函数?

A. y = tanh(x)

B. y = sin(x)

C. y = max(x,0)

D. y = 2x

答案:D。线性函数不能作为激活函数,因为无法引入非线性变换。

15. 我们想在大数据集上训练决策树,为了使用较少时间,我们可以()

A. 增加树的深度

B. 增加学习率 (learning rate)

C. 减少树的深度

D. 减少树的数量

答案:C。减少树的深度可以降低计算复杂度。

增加树的深度 , 会导致所有节点不断分裂 , 直到叶子节点是纯的为止 . 所以 , 增加深度 , 会延长训练时间 .

决策树没有学习率参数可以调. (不像集成学习和其它有步长的学习方法)

决策树只有一棵树, 不是随机森林。

16. 一监狱人脸识别准入系统用来识别待进入人员的身份,此系统一共包括识别 4 种不同的人员:狱警,小偷,送餐员,其他。下面哪种学习方法最适合此种应用需求:

A. 二分类问题

B. 多分类问题

C. 层次聚类问题

D. k-中心点聚类问题

E. 回归问题

F. 结构分析问题

答案:B。这是一个典型的多分类问题。

17. Naive Bayes 是一种特殊的 Bayes 分类器,特征变量是 X,类别标签是 C,它的一个假定是()

A. 各类别的先验概率 P(C) 是相等的

B. 以0为均值,sqr(2)/2为标准差的正态分布

C. 特征变量X的各个维度是类别条件独立随机变量

D. P(X|C)是高斯分布

答案:C。朴素贝叶斯的核心假设是特征条件独立性即iid假设

18. 对于 k 折交叉验证,以下对 k 的说法正确的是()

A. k 越大 , 不一定越好 , 选择大的 k 会加大评估时间

B. 选择更大的k, 就会有更小的bias (因为训练集更加接近总数据集)

C. 在选择k时, 要最小化数据集之间的方差

D. 以上所有

答案:D。这些都是关于k折交叉验证的正确描述。

k越大,就要训练k个模型,计算量越大,所以时间更多;k越大,每次选取的训练集越接近总数据集,所以bias越小;

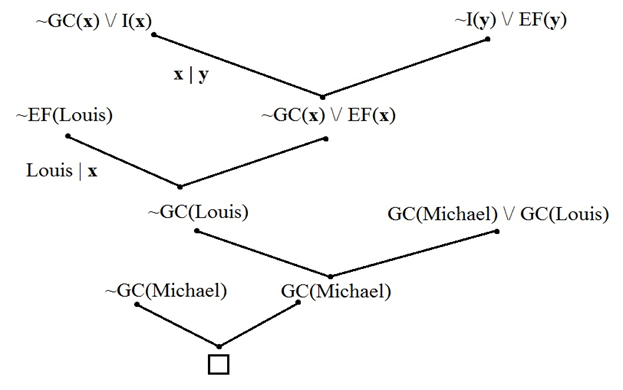

19. 训练决策树模型,属性节点的分裂,具有最大信息增益的图是哪一个()

A. Outlook

B. Humidity

C. Windy

D. Temperature

答案:A。根据图中信息增益的计算,Outlook具有最大的信息增益。

20. 假定某同学使用 Naive Bayesian(NB)分类模型时,不小心将训练数据的两个维度搞重复了,那么关于 NB 的说法中正确的是()

A. 这个被重复的特征在模型中的决定作用会被加强

B. 模型效果相比无重复特征的情况下精确度会降低

C. 如果所有特征都被重复一遍,得到的模型预测结果相对于不重复的情况下的模型预测结果一样

D. 当两列特征高度相关时,无法用两列特征相同时所得到的结论来分析问题

E. NB可以用来做最小二乘回归

F. 以上说法都不正确

答案:BD 假定某同学使用 Naive Bayesian(NB)分类模型时 __ 牛客网

A. 看D就知道,如果两个维度比较相似,那么这两个维度可能高度相关,那么就需要转到D。

B. 当维度重复时,习得的联合概率分布有误,所以精确度会降低。

C. 多出一个维度的特征,其训练出的模型就会有所不同。这与把两个维度的值重复的情况是不同的。

D.两列特征高度相关时(也就是有可能是因为重复了),那就无法用这种疑似重复的特征来分析问题了。

E.最小二乘回归是用在判别式的机器学习方法中,比如SVM,logtic等。它是寻找几何误差最小的预测模型。而贝叶斯是生成式模型。

1. 混淆矩阵的召回率(Recall)公式为?

A. TP/(TP+FN)

B. FN/(TP+FN)

C. TN/(TN+FP)

D. FP/(FP+TN)

答案:A

我记忆的方式是:Precision是以P开头的,所以公式中都有P;Recall是对应的

2. 在构建决策树时,需要计算每个用来划分数据特征的得分,选择分数最高的特征,以下可以作为得分的是?

A. 信息熵

B. 基尼系数(Gini)

C. 训练误差

D. 以上都是

答案:D

3. 下列描述无监督学习错误的是?

A. 无标签

B. 多用于聚类

C. 多用于分类

D. 多用于降维

答案:C

4. 强化学习算法可以分为有模型学习(model-based)算法和免模型(model-free)学习算法,以下属于有模型学习算法的是?

A. Policy Gradient

B. Deep Deterministic Policy Gradient (DDPG)

C. Deep Q Network (DQN)

D. AlphaZero

答案:D

5. 感知器可以解决一下那些问题?

A. 逻辑 " 与 "

B. 逻辑"或"

C. 逻辑"与非"

D. 逻辑"或非"

答案:ABCD

都是线性可分的

与非(NAND)真值表:

| \(A\) | \(B\) | \(\overline{A \cdot B}\) |

|-----|-----|----------------------|

| 0 | 0 | 1 |

| 0 | 1 | 1 |

| 1 | 0 | 1 |

| 1 | 1 | 0 |

或非(NOR)真值表: | \(A\) | \(B\) | \(\overline{A + B}\) | |-----|-----|-------------------| | 0 | 0 | 1 | | 0 | 1 | 0 | | 1 | 0 | 0 | | 1 | 1 | 0 |

6. 如果一个 " 线性回归 " 模型完美地拟合了训练样本,也就是训练样本误差为零,则下面哪个说法是正确的?

A. 测试样本误差始终为零

B. 测试样本误差不可能为零

C. 以上答案都不对

答案:C

7. 在一个线性回归问题中,我们使用 R 平方(R-Squared)来判断拟合度。此时,如果增加一个特征,模型不变,则下面说法正确的是?

A. 如果 R-Squared 增加,则这个特征有意义

B. 如果R-Squared 减小,则这个特征没有意义

C. 仅看 R-Squared 单一变量,无法确定这个特征是否有意义

D. 以上说法都不对

答案:C

8. 下列哪些假设是我们推导线性回归参数时遵循的?

A. X 与 Y 有线性关系(多项式关系)

B. 模型误差在统计学上是独立的

C. 误差一般服从 0 均值和固定标准差的正态分布

D. X 是非随机且测量没有误差的

答案:ABCD

9. 一般来说,下列哪种方法常用来预测连续输出变量?

A. 线性回归

B. 逻辑回顾

C. 线性回归和逻辑回归都行

D. 以上说法都不对

答案:A

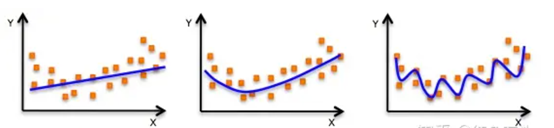

10. 下面三张图展示了对同一训练样本,使用不同的模型拟合的效果(蓝色曲线

A. 第 1 个模型的训练误差大于第 2 个、第 3 个模型

A. 第 1 个模型的训练误差大于第 2 个、第 3 个模型

B. 最好的模型是第 3 个,因为它的训练误差最小

C. 第 2 个模型最为"健壮",因为它对未知样本的拟合效果最好

D. 第 3 个模型发生了过拟合

E. 所有模型的表现都一样,因为我们并没有看到测试数据

答案:ACD

11. 两个变量相关,它们的相关系数 r 可能为 0。这句话是否正确?

A. 正确

B. 错误

答案:A

一般来说,相关系数 r=0 是两变量相互独立的必要不充分条件。也就是说,如果两个变量相互独立,那么相关系数 r 一定为 0,如果相关系数 r=0,则不一定相互独立。相关系数 r=0 只能说明两个变量之间不存在线性关系,仍然可能存在非线性关系。

12. 逻辑回归将输出概率限定在 [0,1] 之间。下列哪个函数起到这样的作用?

A. Sigmoid 函数

B. tanh 函数

C. ReLU 函数

D. Leaky ReLU 函数

答案:A

13. 关于 k 折交叉验证,下列说法正确的是?

A. k 值并不是越大越好,k 值过大,会降低运算速度

B. 选择更大的 k 值,会让偏差更小,因为 k 值越大,训练集越接近整个训练样本

C. 选择合适的 k 值,能减小验方差

D. 以上说法都正确

答案:D

14. 我们知道二元分类的输出是概率值。一般设定输出概率大于或等于 0.5,则预测为正类;若输出概率小于 0.5,则预测为负类。那么,如果将阈值 0.5 提高,例如 0.6,大于或等于 0.6 的才预测为正类。则准确率(Precision)和召回率(Recall)会发生什么变化?

A. 准确率(Precision)增加或者不变

B. 准确率(Precision)减小

C. 召回率(Recall)减小或者不变

D. 召回率(Recall)增大

答案:AC

提高阈值意味着只有更高的概率值(大于或等于 0.6)的样本才会被预测为正类。这会带来以下影响:

-

样本预测变化: - 减少被预测为正类的样本数量 - 原本预测为正类(概率在 0.5-0.6 之间)的样本会被改为负类

-

对准确率(Precision)的影响: - 随着阈值提高,一些误判为正类的样本(FP)被排除 - TP + FP 减少,且 FP 减少比例可能大于 TP 减少比例 - 因此准确率会增加或保持不变(A)

-

对召回率(Recall)的影响: - 随着阈值提高,一些实际为正类的样本(TP)被预测为负类 - TP 减少,而 TP + FN 保持不变 - 因此召回率会减小或保持不变(C)

15. 关于神经网络,下列说法正确的是?

A. 增加网络层数,可能会增加测试集分类错误率

B. 增加网络层数,一定会增加训练集分类错误率

C. 减少网络层数,可能会减少测试集分类错误率

D. 减少网络层数,一定会减少训练集分类错误率

答案:AC

16. 下面哪句话是正确的?

A. 机器学习模型的精准度越高,则模型的性能越好

B. 增加模型的复杂度,总能减小测试样本误差

C. 增加模型的复杂度,总能减小训练样本误差

D. 以上说法都不对

答案:C

17. 如果一个经过训练的机器学习模型在测试集上达到 100% 的准确率,这是否意味着该模型将在另外一个新的测试集上也能得到 100% 的准确率呢?

A. 是的,因为这个模型泛化能力已经很好了,可以应用于任何数据

B. 不行,因为还有一些模型不确定的东西,例如噪声

答案:B

18. 下面有关分类算法的准确率,召回率,F1 值的描述,错误的是?

A. 准确率是检索出相关文档数与检索出的文档总数的比率,衡量的是检索系统的查准率

B. 召回率是指检索出的相关文档数和文档库中所有的相关文档数的比率,衡量的是检索系统的查全率

C. 正确率、召回率和 F 值取值都在 0 和 1 之间,数值越接近 0,查准率或查全率就越高

D. 为了解决准确率和召回率冲突问题,引入了F1分数

答案:C

仅依赖 Precision 或 Recall 可能导致模型无法全面评估,尤其在类别不平衡的情况下。调和平均 比算术平均更倾向于较小的值,因此能够捕捉 Precision 和 Recall 之间的平衡。

19. " 增加卷积核的尺寸,一定能提高卷积神经网络的性能。" 这句话是否正确?

A. 正确

B. 错误

答案:B

20. 假如现在有个神经网络,激活函数是 ReLU,若使用线性激活函数代替 ReLU,那么该神经网络还能表征异或(XNOR)函数吗?

A. 可以

B. 不可以

答案:B

21. 下列哪种方法可以用来减小过拟合?

A. 更多的训练数据

B. L1 正则化

C. L2 正则化

D. 减小模型的复杂度

答案:ABCD

22. 下列说法错误的是?

A. 当目标函数是凸函数时,梯度下降算法的解一般就是全局最优解

B. 进行 PCA 降维时,需要计算协方差矩阵

C. 沿负梯度的方向一定是最优的方向

D. 利用拉格朗日函数能解带约束的优化问题

答案:C

23. 关于 L1、L2 正则化下列说法正确的是?

A. L2 正则化能防止过拟合,提升模型的泛化能力,但 L1 做不到这点

B. L2 正则化技术又称为 Lasso Regularization

C. L1 正则化得到的解更加稀疏

D. L2 正则化得到的解更加稀疏

答案:C

L2 叫岭回归,L1 叫 Lasso 回归;L2 倾向于参数平滑都很小,L1 倾向于参数稀疏。

24. 假定你在神经网络中的隐藏层中使用激活函数 X。在特定神经元给定任意输入,你会得到输出 -0.01。X 可能是以下哪一个激活函数?

A. ReLU

B. tanh

C. Sigmoid

D. 以上都有可能

答案:B

25. 以下哪些方法不可以直接来对文本分类?

A. K-Means

B. 决策树

C. 支持向量机

D. kNN

答案:A

什么是机器学习模型的过拟合和欠拟合?导致模型过拟合的原因有哪些?请结合决策树和神经网络模型进一步阐述解决模型过拟合的方法。

参考答案:

- 过拟合:模型在训练集上错误率很低,但是在未知数据上错误率很高。

- 欠拟合:模型不能很好地拟合训练数据,在训练集和测试集上的错误率都比较高。

- 过拟合的原因:过拟合问题往往是由于训练数据少和噪声以及模型复杂度过高等原因造成的。

- 解决过拟合的方法:

1. 数据层面:增加训练数据、清除数据噪声

2. 模型层面:在经验风险最小化的基础上引入参数的正则化、模型训练提前迭代终止远侧、模型剪枝原则等。

例如,决策树模型可以通过先剪枝操作来控制决策树的生长或通过后剪枝操作对决策树进行修剪。神经网络模型可以通过加入L1正则化或者L2正则化、Dropout、early stopping等

关于机器学习算法评估,分别阐述适用于回归算法和分类算法的评估指标有哪些?并阐述各种评估指标的优缺点。

参考答案:

回归算法评估指标:

a) 平均绝对误差(Mean Absolute Error)

b) 均方误差(Mean Squared Error)

c) 均方根误差(Root Mean Squared Error)

d) 决定系数(Coefficient of determination)

分类算法评估指标:

a) 精度 Accuracy

b) 混淆矩阵 Confusion Matrix

c) 准确率(查准率)Precision

d) 召回率(查全率)Recall

e) Fβ Score

f) AUC Area Under Curve

g) KS Kolmogorov-Smirnov

回归算法评估指标的优缺点举例:

a) MAE虽能较好衡量回归模型的好坏,但是绝对值的存在导致函数不光滑,在某些点上不能求导,可以考虑将绝对值改为残差的平方;

b) MSE与目标变量的量纲不一致;

c) RMSE可以保证量纲一致性;

d) 以上基于误差的均值对进行评估的指标,均值对异常点(outliers)较敏感,如果样本中有一些异常值出现,会对以上指标的值有较大影响。

分类算法评估指标的优缺点举例:

a) 对于有倾向性的问题,往往不能用精度指标来衡量。

b) 对于样本类别数量严重不均衡的情况,也不能用精度指标来衡量。

c) AUC是一种模型分类指标,且仅仅是二分类模型的评价指标。

d) AUC对样本类别是否均衡并不敏感;

机器学习,找到的网上题目 ¶

可以在 tb 上买一天的 csdn 会员

21. 模型的高 bias 是什么意思 , 我们如何降低它?

A. 在特征空间中减少特征

B. 在特征空间中增加特征

C. 增加数据点

D. B和C

E. 以上所有

答案:B。bias太高说明模型太简单了, 数据维数不够, 无法准确预测数据, 所以, 升维吧!

22. 对于信息增益 , 决策树分裂节点 , 下面说法正确的是()

- 纯度高的节点需要更多的信息去区分

- 信息增益可以用 "1 比特 - 熵 " 获得

- 如果选择一个属性具有许多归类值 , 那么这个信息增益是有偏差的

A. 1

B. 2

C. 2和3

D. 所有以上

正确答案是:C

23. 以下哪些算法可以用神经网络去构造?

A. KNN 和线性回归

B. 线性回归和对数几率回归

C. KNN、线性回归和对数几率回归

D. 以上都不是

答案:B

解析:

- KNN算法不需要训练参数,而所有神经网络都需要训练参数,因此神经网络帮不上忙

- 最简单的神经网络感知器,其实就是线性回归的训练

- 我们可以用一层的神经网络构造对数几率回归

24. 位势函数法的积累势函数 K(x) 的作用相当于 Bayes 判决中的()

A. 后验概率

B. 先验概率

C. 类概率密度

D. 类概率密度与先验概率的乘积

答案:A、D

25. 下列关于决策树的说法正确的是()

A. ID3 决策树是根据信息增益来划分属性

B. C4.5决策树是根据增益率来划分属性

C. CART决策树是根据基尼指数来划分属性

D. 基尼指数反映了从样本集D中随机抽取两个样本,其类别标记不一致的概率,因此越小越好

答案:A、B、C、D

26. 以下可以有效解决过拟合的方法是()

A. 增加样本数量

B. 通过特征选择减少特征数量

C. 训练更多的迭代次数

D. 采用正则化方法

答案:A、B、D,增加训练迭代次数不会防止过拟合

27. 在机器学习中需要划分数据集,常用的划分测试集和训练集的划分方法有哪些( )

A. 留出法 (leave one out)

B. 交叉验证法

C. 自助法

D. 评分法

正确答案 : A B C

28. 现在假设负样本量 : 正样本量 =100:1,下列哪些方法可以处理这种极不平衡的情况

A. 直接训练模型,预测的时候调节阈值

B. 复制正样本,以增加正样本数量

C. 随机降采样负样本

D. 训练过程中,增加负样本的权重

正确答案 : B C

解析:解决类别不平衡书中提出三种方法:

1. 下采样

2. 过采样

3. 阈值偏移

深度学习调参一般有哪些参数

-

学习率:常用策略

- 学习率衰减

- 使用自适应学习率优化器,如Adam和Adagrad -

mini batch:

- 小的mini batch size可能因为收敛的抖动比较厉害反而不容易卡在局部最低点

- 但是mini batch也不能太大,反而准确率下降 -

epoch:

- 用早停法选择合适的Epoch

- 观察validation error上升时就early stop

- 但是别一看到上升就停,再观察一下,因为有可能只是暂时的现象,这时候停止反而训练会不充分 -

损失函数:

- 分类一般是softmax

- 回归一般是L2 loss -

激活函数:对于梯度消失现象

- Sigmoid会发生梯度消失的情况,所以激活函数一般不用,收敛不了

- Tanh(x)没解决梯度消失的问题

- ReLu(Max(0,x))比较好,代表Max门单元,解决了梯度消失的问题,而且起到了降维 -

梯度问题:

- 梯度消失:当数值接近于正向∞,求导之后就更小,约等于0,偏导为0

- 梯度爆炸:数值无限大 -

层数:

- 层数越多越灵敏收敛越好,但是容易过拟合

- 可以用Drop-out删除一些无效的节点 -

过拟合解决方案:

- drop-out

- BN (batch normalization,归一化) -

其他模型参数:

- 隐藏层单元数(units)

- 时间序列模型的步长

- RNN的CELL类型(LSTM/GRU)

23/24 秋冬回忆卷 ¶

选择题 ¶

1. 哪个不属于人工智能的运用

选项:编译原理、人工生命等

2. 通过图灵测试,则可以认为

B. 具有人的智能

C. 从表现上来说,能够实现与人相似的智能

具有人的智能

3. 下列哪个算法是按照某种规则遍历搜索空间的算法

A. DFS

B. BFS

C. A*

D. 优先级搜索(例如贪心搜索、Dijkstra)

4. 机器学习是

A. 人工智能的一种分支

B. 数据分析的一种技术

5. 下面哪种算法不是盲目搜索

选项:宽度优先搜索、深度优先搜索等

6. 判断谓词语句是否成立

应该是逻辑部分用归结原理假言定理等推理矛盾

7. 关于欠拟合定义

选项:在训练集表现良好,测试集上表现很差等

8. 下面哪些是常用的算法评价指标

A. 准确率召回率

B. MSE

C. MAE

D. AUC-ROC曲线和PR曲线

准确率、召回率、MSE、MAE、AUC-ROC 曲线和 PR 曲线都是常用的算法评价指标。

其中准确率、召回率、AUC-ROC曲线和PR曲线主要用于分类问题,

MSE(均方误差)和MAE(平均绝对误差)主要用于回归问题。

其中 \(y_i\) 是真实值,\(\hat{y}_i\) 是预测值,n 是样本数量。

9. 下面哪些指标可以评价回归

A. MAE

B. MSE

C. binary cross-entropy

D. L1-smooth

10. 贝叶斯计算

概统简单题

11. 下面哪种算法属于强化学习

12. 人类智能特性

选项两短两长,有一选项为感知、学习、适应、创新

13. 如果假设空间很大,应该用哪种方法搜索

选项忘了

14. 关于人脸识别的流程顺序正确的是

人脸识别的基本流程顺序为: 人脸检测 、关键点检测、人脸对齐 (通过关键点信息使人脸摆正)、特征提取 、人脸比对

15. 如果存在最优解,哪个算法一定能找到

A. BFS

B. 启发式

C. DFS

D. 有限深度

16. 概念学习定义

概念学习定义:

从有关某个布尔函数的输入输出训练样例中推断出该布尔函数

填空题 ¶

1. f(n)=g(n)+h(n) 中 g(n) 和 h(n) 的含义

g(n) 表示从初始状态到当前状态的实际代价,h(n) 表示从当前状态到目标状态的估计代价

2. 人工智能的三个学派分别为

人工智能的三个学派分别为 符号主义、连接主义、行为主义

3. 人工智能的短期目标和长期目标分别是

人工智能的短期目标和长期目标分别是 制造智能机器、实现机器智能

4. BFS 存储待搜索节点的数据结构_,DFS 存储已搜索节点的数据结构_

队列,栈

5. 根据 Agent 是否理解其所处的环境,将强化学习分为和

基于模型和免模型

6. Find-S 用_序的方法,在_ 结构上实现,每一步得到的假设都是在那一点上与训练样例一致的 _____ 假设

more general than 偏序、偏序链、最特殊的

简答题 ¶

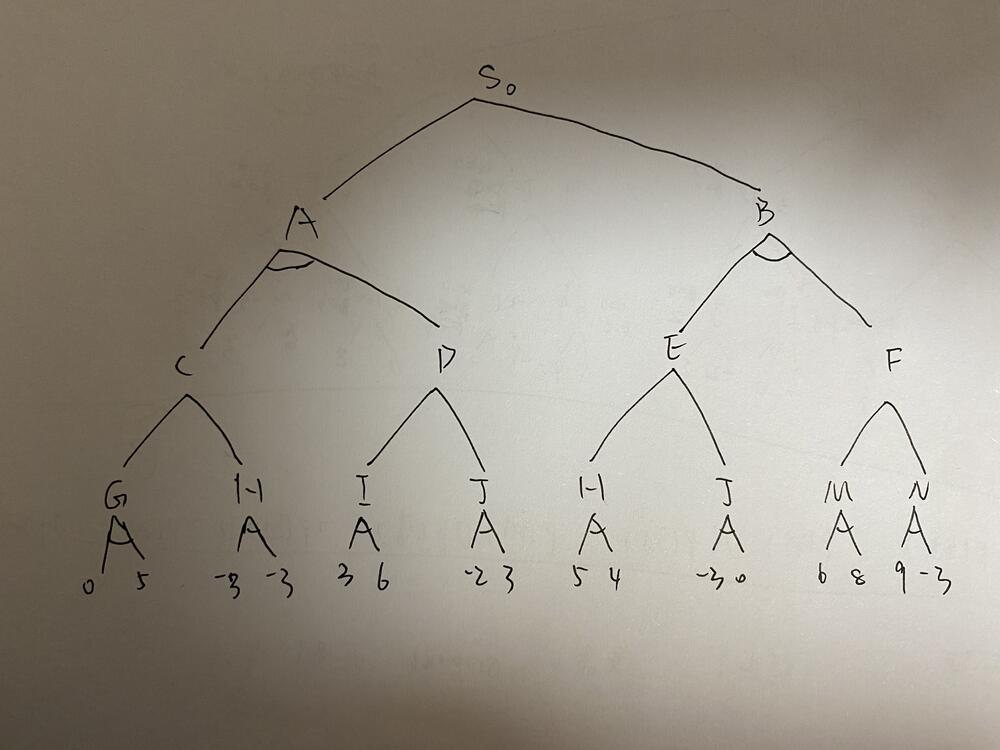

1. alpha-beta 剪枝

根据极大极小算法,简述 alpha-beta 剪枝的原理然后完成剪枝

(1)对抗搜索节点回推值 (2)alpha-beta剪枝原理 (3)alpha-beta剪枝结果

2. 逻辑推理

已知 " 凡是干净的东西就有人喜欢 "" 没人喜欢苍蝇 "

(1)定义谓词 (2)写出逻辑表达式 (3)转换为标准子句 (4)利用归结原理证明 " 苍蝇不干净 "

3. 过控流程设计

过控流程中有数据收集与分析、系统建模、控制系统设计、离线验证与测试、实地部署。请你设计流程,用至少三种本门课学习的方法解决可能遇到的问题,并说明可行性

4. 决策树

描述决策树的原理和优缺点

5. 朴素贝叶斯

描述朴素贝叶斯分类器的原理和应用场景

6. 梯度消失

描述梯度消失的概念和影响,谈谈自己的理解

7. Q-Learning

介绍 Q-Learning 并说明在强化学习中的作用

22/23 秋冬 A 卷 ¶

一、选择题(2 分一道,20 道,单选、多选混合)¶

1. 人工智能定义 2.k折交叉验证 3.朴素贝叶斯分类器的假设前提 4. 一个人用Naive beyesian算某个特征得时候算了两遍,影响是:该特征决定能力增大;预测能力变弱、如果每个特征都重复算一遍则不影响;两个相似的特征不能用同一特征来表示;以上都错 5.有监督和无监督学习 6.激活函数 7.深度优先算法的实现 8.信息增益的计算 9.命题逻辑

假设最优解存在,以下哪个搜索算法能够能找到最优解: A。广度优先(肯定不对,完备性:分叉b为无穷就找不到啦,最优性:前提是越浅的越优,不存在又深又更好的解) B。深度优先(肯定不对,完备性就不一定) C。有限深度优先(肯定不对,没有最优性) D。启发式(肯定不对,取决于h(n)的设计,比如贪婪最好就没有)

二、简答题(5 分一道,4 道)¶

1. 智能的四种能力

- 感知能力

- 学习和自适应能力

- 记忆和思维能力

- 行为能力(人们对感知到的外界信息作出动作反应的能力)

2. 人工智能的短期和终极目标

短期目标:制造智能机器

终极目标:实现机器智能

3. P 为原子谓词公式,则 P 和 ~P 为 _____

互补

4. Find-S 算法

5. 若 P,R 为 F,Q 为 T,则 (P∨R)→Q 为 ___

T

6. Teacher(father(Zhan)) 的个体是

zhan,father(zhan)

三、大题 ¶

1. α-β 剪枝

- 倒推出下图各节点的权值

- 简述 α-β 剪枝的原理

- 用 α-β 剪枝,写出哪些分支可以剪掉

2. 评估函数

评估函数是什么,g(x),h(x) 分别有什么作用

3. 归结推理

赵钱孙李四个人有人偷了张的东西。👮出动了 5 个侦探,A 说赵和钱必有一个偷东西,B 说钱和孙必有一个偷了,C 说孙和李必有一个偷了,D 说赵和钱必有一个没偷,E 说孙和李必有一个没偷。要用归结的方式证明是谁偷了东西。

0101,1010,0110 都可以,顺序是:赵,钱,孙,李

3. 算法评估指标

算法评估中回归算法和分类算法有哪些指标?他们的优缺点分别是什么。

4. 过拟合与欠拟合

过拟合和欠拟合是什么?产生的原因又是什么?以决策树和神经网络为例,概述防止过拟合的方法

22/23 秋冬 B 卷 ¶

一、选择题 ¶

1. 如果问题存在最优解,则下面几种搜索算法中,哪种可以认为是 ' 智能程度相对比较高 ' 的算法

A. 深度优先搜索 B. 宽度优先搜索 C. 有界深度优先搜索 D. 启发式搜索

答案:D

2. 非 (P 且 Q)=( 非 P) 或 ( 非 Q) 是什么律

答案:德摩根律

3. 人类智能具有的 4 项特性为

答案:自主性、反应性、适应性、社会性

4. 不属于知识的特征有哪些

选项有 " 复杂性与明确性 "" 进化性相对性 "

答案:相对正确性、不确定性、可表示性

5. 贝叶斯公式考察

答案:

6. 强化学习中属于有模型算法的为

答案:AlphaZero

7. 关于搜索算法,下列说法错误的有

A. 宽度优先搜索可以看作一致代价搜索的特殊情况 B. 一致代价搜索可看作A*搜索的特殊情况 C. 贪婪最佳优先搜索是完备的 D. 爬山法可以到达起点附近的最佳点

答案:C

8. 给定谓词公式转换为子句式的结果是

答案:

9. 属于回归算法评估指标的有

选项有 MAE, MSE, binary cross entropy 等

答案:MAE, MSE,l1-loss l1-smooth

10. 智能包含的四类能力

答案:感知能力、学习和自适应能力、记忆和思维能力、行为能力

11. 不属于人工智能三大学派的有

选项有符号主义学派,连接主义学派,控制论学派,信息论学派

答案:控制论学派,信息论学派;三大学派:符号主义学派,连接主义学派,行为主义学派

12. 无监督学习不可以用来做什么

选项有 " 分类 "" 数据降维 "," 聚类 "

答案:分类

二、填空题 ¶

1. 谓词与函数的区别

答案:谓词返回真假值,函数返回具体的值

2. 若要用反证法证明 P→Q,即需要证()

答案:P 且非 Q 为假

3. 给了永真的概念表述,问永真

答案:在任何解释下都为真的公式

4. 评价函数中 h(n) g(n) 的含义,其中()又可叫效用函数

答案:h(n) 是启发函数,g(n) 是实际代价,h(n) 又可叫效用函数

5. 个体常量、变元、函数统称为()

答案:个体

6. 图灵测试的目的为()

答案:判断机器是否具有与人类相似的智能

三、大题 / 简答题 ¶

1. 列举至少三种盲目搜索算法并简述其思想(4')

2. 决策树算法中以什么为依据来划分节点?请说明如果以序号作为划分属性,为什么不能用基于信息增益的划分方式。

3. 多变量决策树的优点与缺点(5')

答案:

多变量决策树的优点: 1. 可以处理非轴平行的决策边界,提高分类准确性 2. 可以减少树的深度,提高模型的可解释性 3. 对数据的利用更充分,可以发现属性间的相关性

缺点: 1. 计算复杂度高,训练时间长 2. 容易过拟合 3. 模型解释性相对较差,不如单变量决策树直观 4. 对噪声数据更敏感

4. 神经网络过拟合问题的解决方式(5')

5. 神经网络中梯度消失与梯度爆炸的产生原因,以及如何避免

答案:

神经网络中梯度消失和梯度爆炸的原因:

-

梯度消失 - 使用 sigmoid、tanh 等饱和激活函数,导数值域在(0,1)之间 - 多层网络中,每层的梯度会连乘,导致梯度越来越小 - 网络层数过深时尤其明显

-

梯度爆炸 - 权重初始化不当,值过大 - 学习率设置过大 - 网络层数过深时梯度累积

解决方法:

-

梯度消失 - 使用 ReLU 等非饱和激活函数 - 使用残差连接(ResNet) - 使用 Batch Normalization - 合理初始化权重

-

梯度爆炸 - 梯度裁剪(Gradient Clipping) - 使用 L1/L2 正则化 - 使用 Batch Normalization - 调小学习率 - 合理初始化权重

6. 考归结原理,比较简单

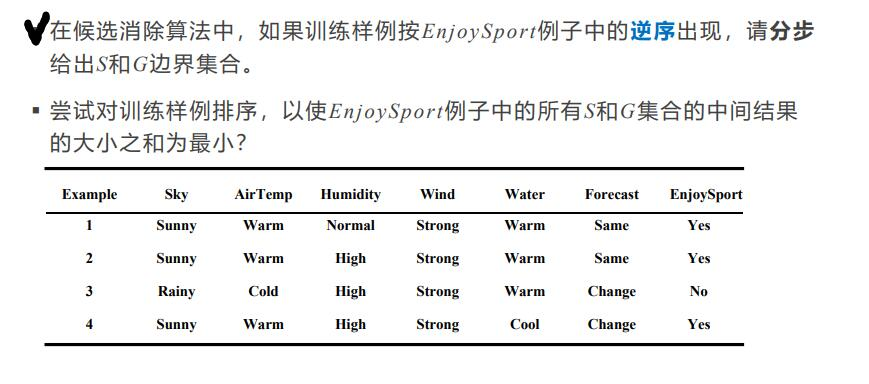

7. 候补消除算法,是作业题,下图中打勾的那问

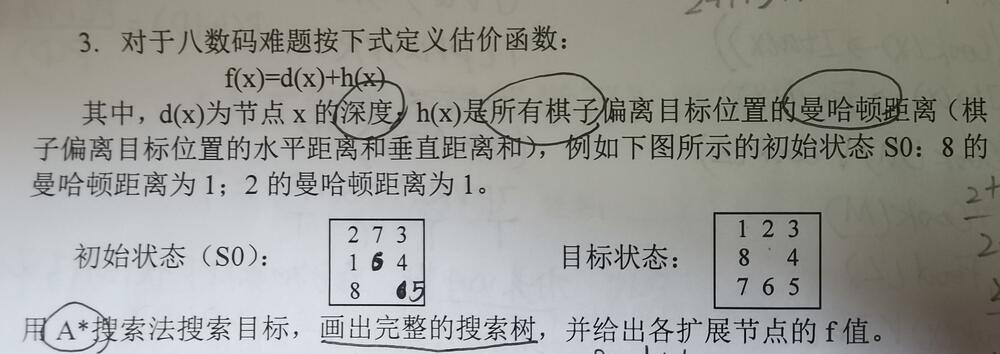

8. 八数码问题(背景要求同小测题 见下图,不过问题问法不同)

(1)请你设计评价函数 f(x)

(2)给出了各步搜索的图示,问各步的评价函数f(x)的值(会算就行,不用画图)

(3)请填写每一步搜索的open-closed表

其他题目 ¶

简答题 ¶

1. 效用函数

\(f\) 是启发式搜索的效用函数,是当前路径的评价指标;\(g\) 是得分函数,代表当前点到目标点的得分,\(h\) 是耗散函数,代表当前点到起始点的距离。

2. 对抗搜索与 αβ 剪枝

这题给了一个对抗搜索树,在最末端给出了他们的值,要求把每一个节点的值都表示出来;然后进行 αβ 剪枝。

3. 学习率对神经网络的影响

太大不收敛,太小学不动。

4. 信息增益的公式以及何时它达到最大

信息增益的公式为:

信息增益在以下情况下达到最大: 1. 当属性\(a\)将数据集\(D\)完全划分为纯净的子集时,即每个子集\(D^v\)中的样本都属于同一类别 2. 当属性\(a\)的划分使得子集的熵之和最小时 3. 当属性\(a\)的划分使得类别的分布最均匀时

需要注意的是,信息增益倾向于选择取值较多的属性,这可能导致过拟合。为解决这个问题,可以使用信息增益率等改进指标。

大题 ¶

1. 深度优先搜索和广度优先搜索

给了一个课上类似但简化了的地图,要求用两种方法搜索 A 至 E 的最佳路径;然后对两种方法进行对比。

3. 极大似然假设

D 中含有 \(x_i\) 和 \(y_i\),\(y_i=h(x_i)+e_i\),\(e_i\) 服从偏差为零的正态分布,求证极大似然假设等价于 \(y_i\) 和 \(h(x_i)\) 的平方和误差最小。

要使其最大,就要使 \(y_i\) 和 \(h(x_i)+e_i\) 尽可能接近,即 :

4. 决策树

根据气温、天气、温度、适度的情况判断是否打网球,给出了十四条数据,根据信息增益算决策树的节点先后顺序。

这个题比较常规,看一下西瓜书上的例题。 但是非常耗时间,如果没有计算器是不可能完成的。

复习 ¶

整理了一下朋友们和各位前辈的分享,感谢大家

(自动化资料也是多起来了 hhh)

复习资料 ¶

- 复习资料 RrQqSsYy

- 复习资料 云高天遥

- 复习资料 zhyyyyyyyy

- 复习资料 handsome-boy

- 复习 ppt+ 平时作业分享 - the_Piao

- 人机复习笔记 - MyAmigo

- 复习笔记 & 题目整理 - PhilFan

- 人机笔记 - 小胖一族

- 笔记与回忆卷整理 - Twinkle

回忆卷 ¶

- 24-25 年 秋冬 回忆卷 FLOG 司马

- 22-24 年 考题整理 - FLOG 司马

- 2022-2023 秋冬 回忆卷 Valkyrie

- 2022-2023 秋冬 回忆卷 桂物

- 2022-2023 秋冬 回忆卷 枕流

- 2022-2023 秋冬 B 回忆卷 XD233

- 23-24 秋冬 复习资料 + 回忆卷 rickyman

- 23-24 秋冬 回忆卷 KrAulegend

- 2023-2024 秋冬《人工智能与机器学习》回忆卷 - CC98 论坛

- 23-24 春 机器人班

- 23-24 春 机器人班级